Diversas organizaciones se han convertido en objetivos de «hackers» para la suplantación de la identidad de sus objetivos y fraudes financieros

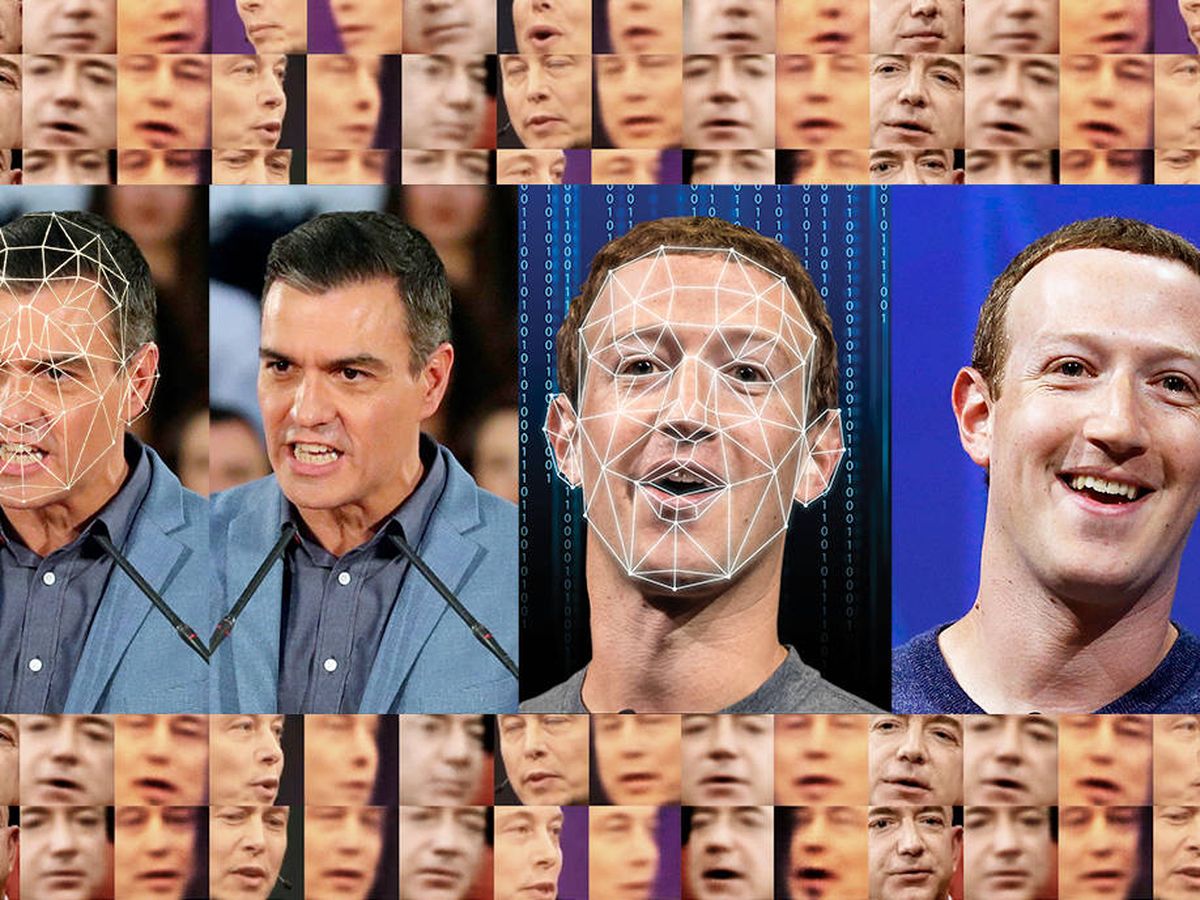

Ante el auge de la tecnología, la creciente amenaza de ‘deepfakes’ se presenta como un auténtico desafío.

Algunos agentes del mercado ya han mostrado su preocupación sobre cómo los usuarios anónimos difunden ‘deepfakes’ para destruir la reputación de empresas concretas

Para la Agencia Central de Inteligencia, los Sistemas de Seguridad Nacional (NSS), la Base Industrial de Defensa (DIB), el Departamento de Defensa (DoD) y los propietarios de infraestructuras críticas nacionales, la amenaza de los medios sintéticos es considerable.

La doble naturaleza de los medios sintéticos

Estas técnicas de medios sintéticos presentan una dualidad intrigante, ofreciendo aplicaciones tanto positivas como maliciosas. A pesar de que existen indicios limitados de la participación de actores patrocinados por estados en la manipulación de medios sintéticos, la proliferación y eficiencia de estas técnicas entre actores cibernéticos maliciosos menos capacitados indican un aumento inminente tanto en frecuencia como en sofisticación.

Las amenazas abarcan un amplio espectro de tecnologías asociadas con texto, video, audio e imágenes, utilizadas en línea y en diversos contextos de comunicación. De particular preocupación son los deepfakes, una categoría de medios sintéticos que aprovecha la inteligencia artificial y el aprendizaje automático para crear contenido notablemente auténtico.

El abuso de los medios sintéticos plantea amenazas sustanciales, como daños a la marca de una organización, suplantación de líderes y oficiales financieros, y el uso de comunicaciones fraudulentas para infiltrarse en redes y acceder a información sensible.

Ante este asedio creciente, se insta a las organizaciones a adoptar un enfoque multifacético para identificar, defenderse y responder a las amenazas de deepfake. La implementación de tecnologías de vanguardia para detectar deepfakes, verificar la procedencia de los medios en tiempo real, utilizar técnicas de detección pasiva y proteger a los funcionarios de alta prioridad y sus comunicaciones son componentes cruciales de esta estrategia de defensa.

Además, se deben tomar medidas proactivas, como el intercambio de información, la planificación para responder a intentos de explotación y la capacitación integral del personal, para minimizar el impacto de las técnicas maliciosas de deepfake. En particular, la creciente amenaza de phishing utilizando deepfakes presenta un desafío adicional, y a las organizaciones se les aconseja prepararse proactivamente para la identificación y contrarresto de estos intentos sofisticados.

Consorcios públicos y privados, como la Coalición para la Procedencia y Autenticidad del Contenido y el Proyecto Origen, ofrecen oportunidades para que las organizaciones colaboren y desarrollen resistencia contra las amenazas de deepfake.

El dilema de la universalización

El panorama de las amenazas de medios sintéticos está evolucionando rápidamente, impulsado por herramientas y técnicas que manipulan medios auténticos. Si bien estas herramientas han existido durante décadas, los avances recientes en la potencia computacional y el aprendizaje profundo han democratizado su accesibilidad. Lo que antes era el dominio de profesionales capacitados ahora puede ser utilizado por adversarios de todo tipo, fomentando campañas de fraude y desinformación contra individuos y organizaciones objetivo.

La universalización de estas herramientas de manipulación ha elevado las amenazas de medios sintéticos al frente de los riesgos principales en este año 2023. Las implicaciones van más allá de la desinformación y la propaganda, planteando desafíos significativos para la seguridad nacional del Gobierno de EEUU, NSS, DIB, organizaciones de infraestructuras críticas y más.

La vulnerabilidad de las organizaciones

Esta vulnerabilidad incluye cuentas falsas en línea en intentos de ingeniería social, mensajes de texto y voz fraudulentos que evitan las defensas técnicas y videos manipulados que difunden desinformación. Las organizaciones de alto perfil se convierten en objetivos de la suplantación de ejecutivos, fraude financiero y acceso no autorizado a comunicaciones y operaciones internas de la organización.

Para navegar por el panorama de amenazas de medios sintéticos, es crucial entender la terminología. Los deepfakes baratos o superficiales, que dependen de técnicas que no involucran aprendizaje automático o profundo, pueden ser tan efectivos como los métodos más sofisticados. Ejemplos incluyen copiar selectivamente contenido para alterar la narrativa y ralentizar videos para distorsionar el estado de una persona.

Por otro lado, los deepfakes creados o editados con aprendizaje automático o profundo representan una nueva frontera en las amenazas de medios sintéticos. Ejemplos destacados incluyen un aumento en las imágenes deepfake en LinkedIn y una escena fabricada generada por IA que causó caos en los mercados financieros. Los deepfakes no se limitan a videos y también abarcan audio, contribuyendo a estafas y intentos de phishing.

La problemática de la detección

A principios de 2023, Generative AI, que incluye Generative Adversarial Networks y Large Language Models, está ganando popularidad para la producción de medios sintéticos. Mientras tanto, la fusión de la Imagen Generada por Computadora (CGI) con la Generative AI mejora la creación de falsificaciones convincentes en medios visuales, anteriormente reservados para producciones cinematográficas importantes.

La batalla continua contra las amenazas de medios sintéticos implica importantes esfuerzos de detección y autenticación. Los métodos de detección, basados en técnicas forenses pasivas, buscan identificar evidencia de manipulación a través de salidas numéricas o visualizaciones.

(Con información de El Cierre Digital)