El estudio, publicado en la revista Nature Neuroscience el 1 de mayo, utilizó un modelo transformador, similar al que impulsa el chatbot de inteligencia artificial ChatGPT de OpenAI, para decodificar los pensamientos de las personas.

Un modelo transformador es una red neuronal que aprende el contexto y, por lo tanto, el significado. Los sujetos de prueba escucharon inicialmente horas de podcasts y se registró la actividad cerebral. Luego, los investigadores entrenaron al decodificador en estas grabaciones. Más tarde, los sujetos escucharon una nueva historia o imaginaron contar una historia, lo que permitió que el decodificador generara el texto correspondiente mediante el análisis de la actividad cerebral.

Los investigadores entrenaron a los decodificadores en tres temas. “Debido a que nuestro decodificador representa el lenguaje utilizando características semánticas en lugar de funciones motoras o auditivas, las predicciones del decodificador deberían capturar el significado de los estímulos”, dijo el estudio.

“Los resultados muestran que las secuencias de palabras decodificadas capturaron no solo el significado de los estímulos, sino también, a menudo, palabras y frases exactas”.

Las tecnologías capaces de leer los pensamientos , sin embargo, plantean preocupaciones sobre la privacidad y la pérdida de libertad.

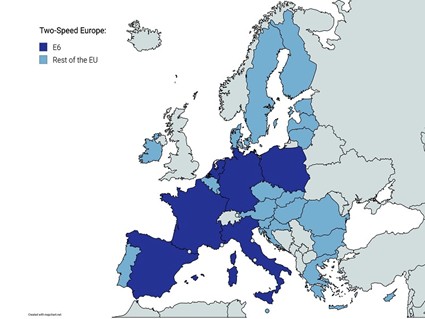

En una entrevista del 17 de marzo con MIT Technology Review, Nita Farahany, especialista en ética legal de la Universidad de Duke en Durham, Carolina del Norte, advirtió que los gobiernos y otros poderes pueden utilizar la recopilación de datos cerebrales con fines nefastos. “Un gobierno autoritario que tenga acceso a ella podría usarla para tratar de identificar a personas que no muestran adhesión política, por ejemplo. Eso es un mal uso bastante rápido y grave de los datos. O tratar de identificar a las personas que son neuroatípicas y discriminarlas o segregarlas”, dijo Farahany.

En un lugar de trabajo, la tecnología se puede utilizar en la «deshumanización» de los empleados obligándolos a someterse a neurovigilancia. “El problema surge si se usa como una herramienta obligatoria y los empleadores recopilan datos para tomar decisiones sobre contratación, despido y promociones. Lo convierten en una especie de puntuación de productividad. Entonces creo que se vuelve realmente insidioso y problemático. Socava la confianza… y puede hacer que el lugar de trabajo sea deshumanizante”.

A diferencia de otros sistemas de decodificación de idiomas que están en desarrollo en la actualidad, el desarrollado por los investigadores en el estudio del 1 de mayo no requiere que los sujetos reciban trasplantes quirúrgicos.

Jerry Tang, coautor del estudio, cree que si bien la tecnología se encuentra en sus primeras etapas, los gobiernos deberían tratar de promulgar políticas que protejan a las personas y su privacidad. “Regular para qué se pueden usar estos dispositivos también es muy importante”.

(Con información